¿Se puede mantener una terapia psicológica con una inteligencia artificial?

En un mundo en el que la inteligencia artificial (IA) se ha integrado a pasos acelerados en casi todos los aspectos de la vida cotidiana, no sorprende que también haya comenzado a ocupar un lugar en un ámbito tan delicado como la salud mental. El aumento de personas que recurren a herramientas basadas en IA para obtener apoyo emocional o psicológico ha dado lugar a un mercado creciente de “psicobots”: asistentes virtuales diseñados para conversar, contener y, en algunos casos, ofrecer consejos terapéuticos.

Aplicaciones como TerapIA, Brain, Panda, FeelBetterBot o Abby ya están disponibles para cualquier persona que haga una rápida búsqueda en línea. Incluso grandes compañías como Google han lanzado herramientas como Tu psicólogo de IA, potenciada por Gemini, que promete ser “un chat con el que puedes hablar y que te responderá con consejos y herramientas para ayudarte con tu salud mental”.

Pero esta proliferación de herramientas plantea una pregunta urgente: ¿puede una IA, por muy avanzada que sea, sustituir el acompañamiento humano en una terapia psicológica?

Primer ensayo clínico: ¿un punto de inflexión?

Recientemente, un equipo de psiquiatras y psicólogos de la Facultad de Medicina Geisel del Dartmouth College (EE.UU.) desarrolló Therabot, una IA terapéutica entrenada con datos cuidadosamente seleccionados y prácticas profesionales basadas en la evidencia. Su eficacia fue puesta a prueba en un ensayo clínico con 210 personas que presentaban síntomas de depresión, ansiedad o riesgo de trastornos alimentarios.

Los resultados fueron sorprendentes: se reportó una disminución del 51% en síntomas de depresión, 31% en ansiedad y 19% en preocupaciones relacionadas con la imagen corporal. Estos efectos fueron comparables con los que suele obtenerse tras 16 horas de psicoterapia tradicional.

Sin embargo, los expertos advierten que estos resultados no pueden generalizarse a todos los psicobots disponibles, ya que la mayoría no ha sido creada ni supervisada por profesionales clínicos, ni se apoya en datos confiables.

¿Una ayuda o un atajo peligroso?

Para muchos usuarios, hablar con una IA puede parecer más fácil que abrirse a una persona. Las máquinas no juzgan, tienen paciencia infinita y responden de inmediato. Esta facilidad puede hacer que algunas personas se sientan más cómodas y empiecen a explorar temas sensibles.

Desde esta perspectiva, los psicobots pueden ser una puerta de entrada a la terapia, especialmente para quienes sienten vergüenza o miedo de pedir ayuda. Pero los especialistas aclaran que ese primer paso no debería confundirse con un tratamiento completo.

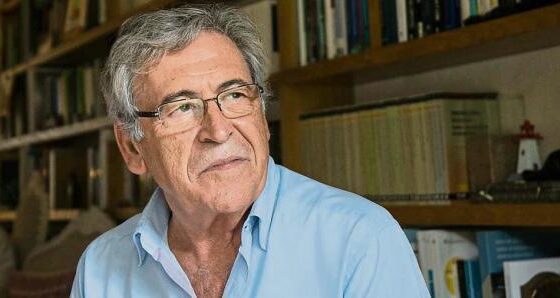

Según Neus Vidal-Barrantes, catedrática de Psicología Clínica en la Universitat Autònoma de Barcelona (UAB), la alianza terapéutica —la calidad del vínculo entre paciente y terapeuta— es el predictor más fuerte de mejora en salud mental. Y eso, afirma, no puede ser replicado por un robot. La intervención terapéutica requiere escucha activa, comprensión emocional, juicio clínico y adaptación constante, capacidades que aún escapan al alcance de cualquier algoritmo.

Riesgos de trivializar la salud mental

La facilidad de acceso a estos asistentes puede llevar a pensar que “algo es mejor que nada”, pero eso también puede ser peligroso. Si una persona acude a un psicobot esperando contención real y no encuentra una respuesta adecuada, puede sentirse aún más sola o desmotivada para buscar ayuda profesional.

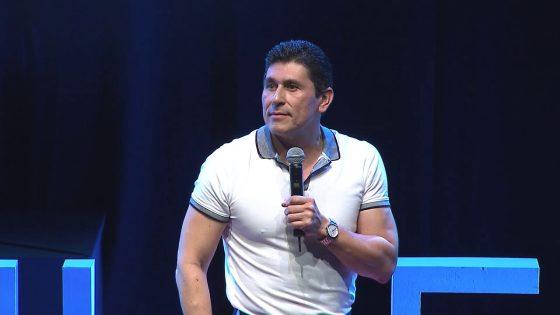

Carlos Losada, vocal de la Sociedad Española de Psicología Clínica, señala que el uso de IA debe estar siempre supervisado por profesionales capacitados, y que no se puede permitir que el marketing de las empresas tecnológicas eclipse los límites reales de estas herramientas. De hecho, recuerda que un porcentaje de pacientes puede incluso empeorar en tratamientos psicológicos mal conducidos, tanto por humanos como por sistemas automatizados.

Además, advierte sobre un aspecto clave que muchas veces pasa desapercibido: la privacidad de los datos. ¿Qué ocurre con la información emocional y psicológica que los usuarios entregan a estas plataformas? En un mundo donde ya se han utilizado datos de salud para propósitos legales o comerciales, confiar nuestras emociones a un bot sin saber qué uso se dará a esa información es un riesgo que no debería tomarse a la ligera.

IA certificada y con supervisión: el único camino posible

Jordi Albó, experto en robótica afectiva, coincide en que las IA pueden aportar valor en la recopilación de información y seguimiento de pacientes, pero insiste en que nunca deben operar solas. Su uso puede ser útil como complemento, no como sustituto de la figura del terapeuta humano. Y en caso de usarse, deberían contar con certificaciones, auditorías y respaldo institucional, del mismo modo que ocurre con los dispositivos médicos.

Los problemas de salud mental son complejos, multifactoriales y profundamente humanos. Pretender resolverlos con soluciones “rápidas” no solo es ingenuo, sino que puede terminar dañando más que ayudando. No todos necesitan psicoterapia, pero quienes la requieren merecen una atención digna, empática y segura.

Conclusión: ¿avance o amenaza?

La irrupción de la inteligencia artificial en el campo de la salud mental representa una oportunidad, pero también un desafío ético, clínico y social. Herramientas como Therabot demuestran que una IA bien diseñada y validada científicamente puede ser un recurso útil, especialmente si se utiliza como complemento al trabajo clínico humano.

Sin embargo, abrirle la puerta a cualquier psicobot disponible en internet, sin filtros ni garantías, es un riesgo que no debería asumirse a la ligera. La salud mental no es un juego de programación ni un experimento tecnológico. Requiere escucha, empatía, juicio y humanidad. Y por ahora, eso sigue estando fuera del alcance de cualquier algoritmo.